语言:中文 | English

这个工程介绍了如何在免费的云资源上部署独立的ChatGLM-6B大模型,并将大模型应用到Chat2DB客户端中。

!!!请注意,为了在消费级显存上也能部署大模型,本教程部署的是ChatGLM-6B的4bit量化模型,模型准确性会有所下降,仅供大家实验参考,切勿迁怒于模型或产品。

| 模型 | 最低GPU显存(推理) | 最低GPU显存(高效参数微调) |

|---|---|---|

| ChatGLM-6B-int4 | 6GB | 7GB |

- Google colab 每天有免费12小时的使用机会,如果对Google colab不熟悉,可以简单百度一下教程,非常简单。打开 chatglm-6b-int4-deploy.ipynb. 拷贝一份副本到你自己的Google colab账号中。

- 依次执行步骤1到步骤6的代码,一定要记得将步骤6中的web_demo.py文件换成本工程中的web_demo.py文件。

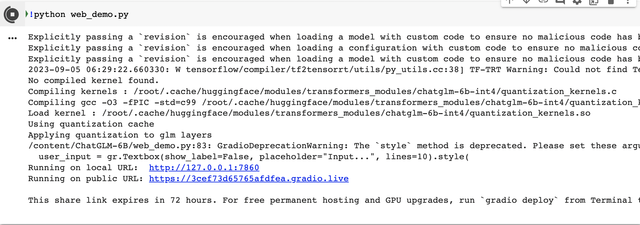

- 执行步骤6之后你将得到一个类似下图中的URL

https://3cef73d65765afdfea.gradio.live. 点击URL之后即可开始demo体验了,第一轮对话初始化耗时较长,后续对话会相对快一点,点击Google colab中的stop按钮停止demo体验。

- 注意: 因为我们是在Google colab上部署的模型,所以网络有可能比较慢,模型下载和运行的时间可能会比较长,请耐心等待。

- 如果觉得在云资源上部署模型体验不够丝滑,你也可以在你的本地机器上部署,部署步骤和在Google colab上的部署步骤是一样的。请参考 chatglm-6b-int4-deploy.ipynb 中的代码。

- 注意: 在本地部署的时候记得将本工程中的web_demo.py文件和api.py文件中的/content/chatglm-6b-int4路径换成你本地机器上的chatglm-6b-int4模型路径。另外,记得将chat2db客户端中的api url换成你本地机器上的api url。